Depuis le 1er août 2024, l’Union européenne dispose d’un cadre juridique inédit pour encadrer le développement et l’utilisation de l’intelligence artificielle (IA). Inspiré des réglementations européennes en matière de sécurité des produits, ce règlement sur l’IA poursuit deux objectifs majeurs : protéger les citoyens face aux risques liés à l’IA et favoriser l’émergence d’un marché unique de l’« IA de confiance » à l’échelle européenne.

Un champ d’application large mais ciblé

Le texte s’applique à tout système d’IA, défini comme un dispositif automatisé, autonome à divers degrés, qui génère des résultats susceptibles d’influencer le monde réel ou virtuel. Sont concernés tous les acteurs – qu’ils soient européens ou non – dès lors que leurs systèmes ou leurs effets sont accessibles aux utilisateurs de l’UE.

Le règlement distingue clairement les systèmes (ensemble fonctionnel incluant interfaces et traitements de résultats) des modèles d’IA (comme ceux utilisés dans l’IA générative), ce qui permet une régulation plus fine selon les usages.

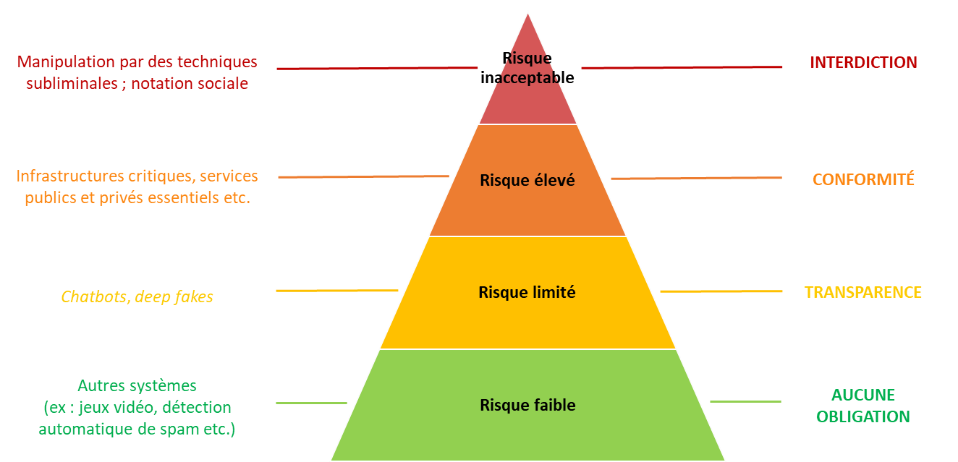

Une régulation fondée sur les niveaux de risque

Le cœur du dispositif repose sur une approche par les risques, avec une catégorisation des systèmes selon leur potentiel de nuisance :

Risque minimal : libre circulation sans contrainte particulière.

Risque limité : obligations d’information de l’utilisateur.

Risque élevé : cadre strict (documentation, gestion des risques, auditabilité).

Risque inacceptable : interdiction pure et simple (ex. : manipulation cognitive, notation sociale).

Les systèmes à haut risque concernent notamment des domaines sensibles comme la biométrie, la santé, l’éducation, le maintien de l’ordre, l’accès à l’emploi… ou encore, dans le secteur financier, l’évaluation de la solvabilité ou la tarification en assurance santé et vie.

Des obligations spécifiques pour les systèmes à haut risque

Les développeurs et utilisateurs de ces systèmes devront notamment : garantir une traçabilité complète des opérations ; utiliser des données de haute qualité pour l’apprentissage ; mettre en place une supervision humaine ; évaluer les impacts sur les droits fondamentaux.

Pour les acteurs financiers, une articulation est prévue avec la réglementation existante. L’ACPR (Autorité de contrôle prudentiel et de résolution) jouera un rôle central de supervision dans ce secteur.

Un encadrement inédit pour l’IA générative

L’arrivée rapide des modèles d’IA à usage général comme ChatGPT a poussé l’UE à adapter le règlement. Ces modèles, capables d’exécuter de multiples tâches, sont soumis à : des obligations de transparence et de documentation (hors open source) ; des contraintes renforcées pour les modèles à risque systémique, en fonction de leur puissance de calcul.

Favoriser l’innovation via les bacs à sable réglementaires

Conscient de la nécessité de soutenir l’innovation, le règlement prévoit la mise en place de bacs à sable réglementaires (« sandboxes »), où les fournisseurs pourront tester leurs systèmes dans un environnement contrôlé, en bénéficiant d’une certaine flexibilité.

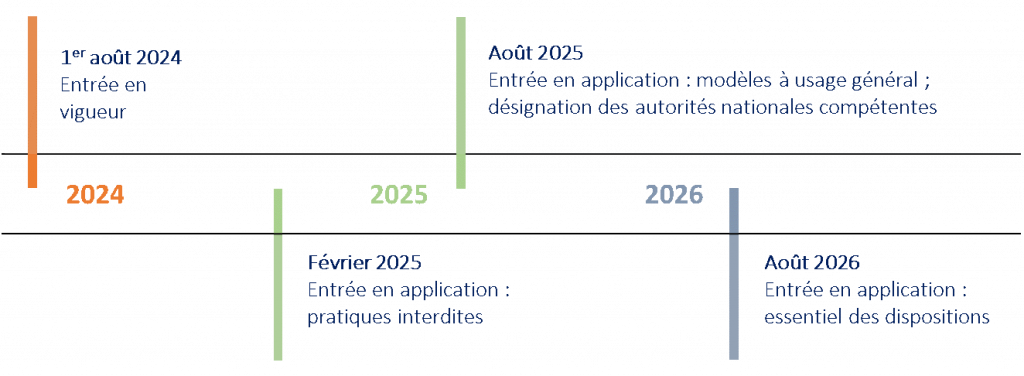

Calendrier d’application échelonné

Si certaines dispositions sont applicables immédiatement (notamment celles concernant les pratiques interdites et les modèles à usage général), la plupart des obligations entreront en vigueur d’ici août 2026, laissant aux acteurs du marché un délai de deux ans pour se mettre en conformité.

Le règlement sur l’IA marque une avancée historique dans la régulation des technologies numériques en Europe. Il impose des garanties solides tout en favorisant l’innovation responsable. Reste désormais à surveiller sa mise en œuvre effective – notamment dans les secteurs sensibles comme la finance, où les enjeux éthiques, économiques et sociaux sont particulièrement cruciaux.